硬件条件

至少 16GB RAM(建议 32GB 或更高)。

至少 50GB 可用存储空间。

支持 CUDA 的 GPU(可选,用于加速推理)

Linux中Ollama的安装

Ollama 是一个开源工具,专注于简化大型语言模型(LLMs)的本地部署和管理。它允许用户在本地计算机上运行各种 AI 大模型(如 Llama、DeepSeek、Mistral 等),而无需依赖云服务。

ollama项目网站:

1.基于CPU:

使用docker安装ollama

docker pull ollama/ollama2.随后安装ollama容器:

docker run -d -v $PWD/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama默认监听端口为11434,可供修改

在浏览器中打开localhost+":11434"若出现 "ollama is running"则代表ollama已经部署成功。

之后若是把ollama容器服务停掉了,要重新启动需用命令:

docker start /ollama2. 基于GPU(对服务器硬件要求高)

首先同样需要通过docker命令"docker pull ollama/ollama"下载ollama,其次是安装GPU相关的工具套件。

然后输入安装基于GPU的docker安装命令:

docker run -d --gpus=all -v $PWD/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollamaollama中安装模型

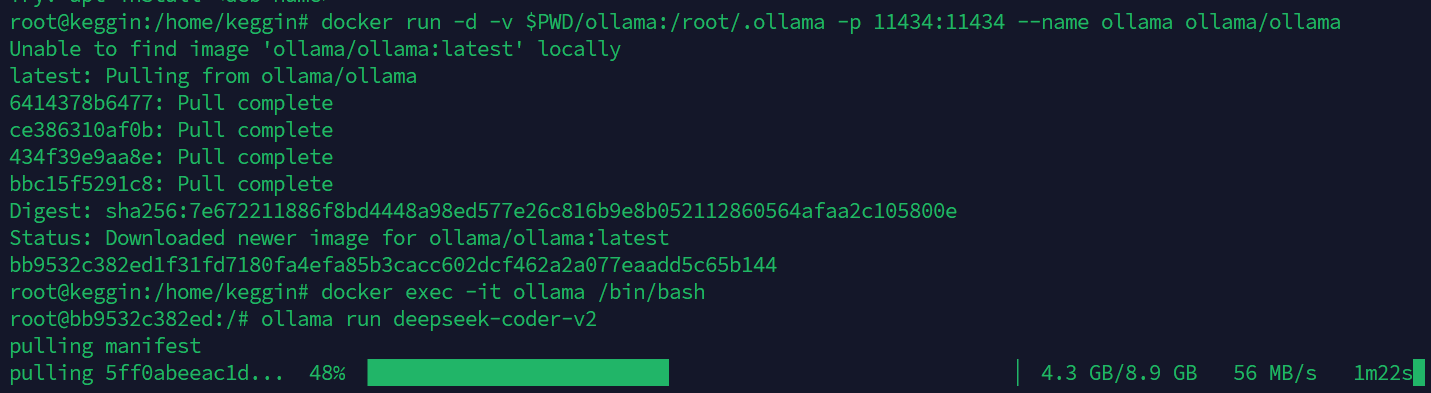

首先运行以下命令进入ollama容器:

docker exec -it ollama /bin/bash下表汇总了常见开源项目大语言模型的安装脚本:

| 模型名称 | 加载命令 | 模型大小和说明 |

|---|---|---|

| codegeex4 | ollama run codegeex4 | (9B, 5.5GB),功能强大的代码生成模型 |

| codeqwen | ollama run codeqwen | (7B, 4.2GB),阿里巴巴开发的代码模型,在吾爱破解翻译能力比较强 |

| wizardcoder | ollama run wizardcoder | (6.74B, 3.8GB),2023年发布的新代码生成模型 |

| wizardcoder:33b | ollama run wizardcoder:33b | (33B, 19GB),被称为state-of-the-art代码生成模型,参数较多 |

| stable-code | ollama run stable-code | (3B, 1.6GB),轻量级模型,推理速度相对较快 |

| glm4 | ollama run glm4 | (9.4B, 5.5GB),智能语言推理模型大变革,性能优于llama3 |

| deepseek-coder-v2 | ollama run deepseek-coder-v2 | (16B, 9.8GB),236B版本上了代码生成的顶级模型 |

| qwen2.5:7B | ollama run qwen2.5 | (7B, 4.7GB),阿里巴巴发布的开源通用大模型 |

| qwen2.5:3b | ollama run qwen2.5:3b | (3B, 1.9GB) 阿里巴巴发布的3B版本开源通用大模型 |

| llama3.2:3b | ollama run llama3.2 | (3B, 2.0GB) Meta推出的轻量化大模型 |

| llama3.2:1b | ollama run llama3.2:1b | (1B, 1.3GB) Meta推出的轻量化大模型,CPU性能更优 |

| gemma:2b | ollama run gemma:2b | (2B, 1.7GB) Google Deepmind推出的轻量化模型 |

以deepseek-14B的安装为例,出现以下命令行表示成功:

在安装完成之后,同样打开网站,"locahost:11434/api/tags”如果返回诸如这样的模型代码和参数数据则表示成功:

{"models":[{"name":"nomic-embed-text:latest","model":"nomic-embed-text:latest","modified_at":"2025-02-06T08:42:55.965336437+08:00","size":274302450,"digest":"0a109f422b47e3a30ba2b10eca18548e944e8a23073ee3f3e947efcf3c45e59f","details":{"parent_model":"","format":"gguf","family":"nomic-bert","families":["nomic-bert"],"parameter_size":"137M","quantization_level":"F16"}},{"name":"deepseek-r1:32b","model":"deepseek-r1:32b","modified_at":"2025-02-03T16:54:51.179951968+08:00","size":19851337640,"digest":"38056bbcbb2d068501ecb2d5ea9cea9dd4847465f1ab88c4d4a412a9f7792717","details":{"parent_model":"","format":"gguf","family":"qwen2","families":["qwen2"],"parameter_size":"32.8B","quantization_level":"Q4_K_M"}},{"name":"deepseek-r1:70b","model":"deepseek-r1:70b","modified_at":"2025-01-25T02:54:18.987720785+08:00","size":42520397704,"digest":"0c1615a8ca32ef41e433aa420558b4685f9fc7f3fd74119860a8e2e389cd7942","details":{"parent_model":"","format":"gguf","family":"llama","families":["llama"],"parameter_size":"70.6B","quantization_level":"Q4_K_M"}},{"name":"bge-m3:latest","model":"bge-m3:latest","modified_at":"2025-01-23T16:34:09.394063525+08:00","size":1157672605,"digest":"7907646426070047a77226ac3e684fbbe8410524f7b4a74d02837e43f2146bab","details":{"parent_model":"","format":"gguf","family":"bert","families":["bert"],"parameter_size":"566.70M","quantization_level":"F16"}},{"name":"smollm2:135m","model":"smollm2:135m","modified_at":"2025-01-15T09:10:15.15811284+08:00","size":270898672,"digest":"9077fe9d2ae1a4a41a868836b56b8163731a8fe16621397028c2c76f838c6907","details":{"parent_model":"","format":"gguf","family":"llama","families":["llama"],"parameter_size":"134.52M","quantization_level":"F16"}}]}基于page assist的web UI的ollama调用

page assist的项目地址:

page assist的插件安装地址:

https://chromewebstore.google.com/detail/page-assist-%E6%9C%AC%E5%9C%B0-ai-%E6%A8%A1%E5%9E%8B%E7%9A%84-web/jfgfiigpkhlkbnfnbobbkinehhfdhndo

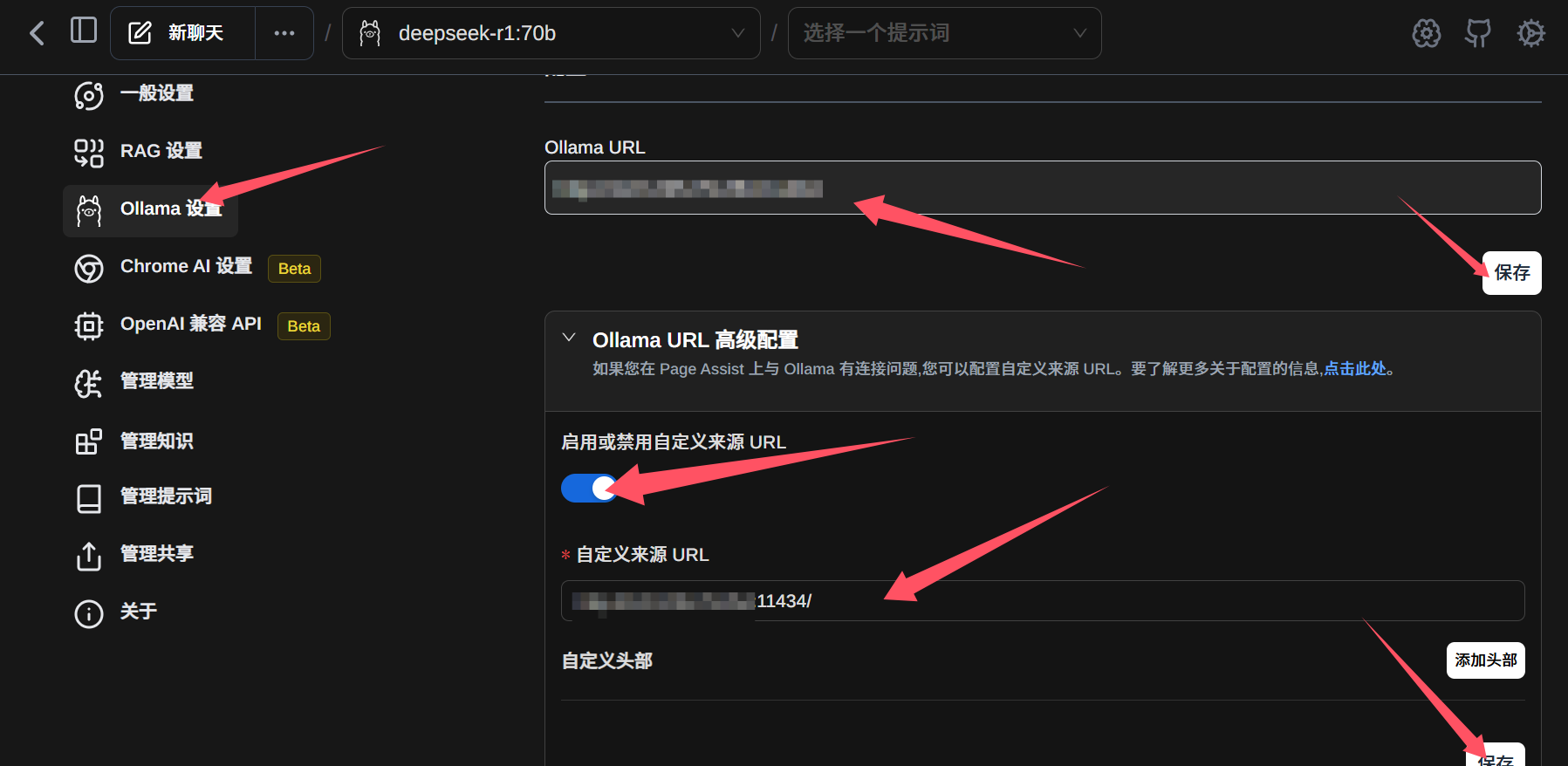

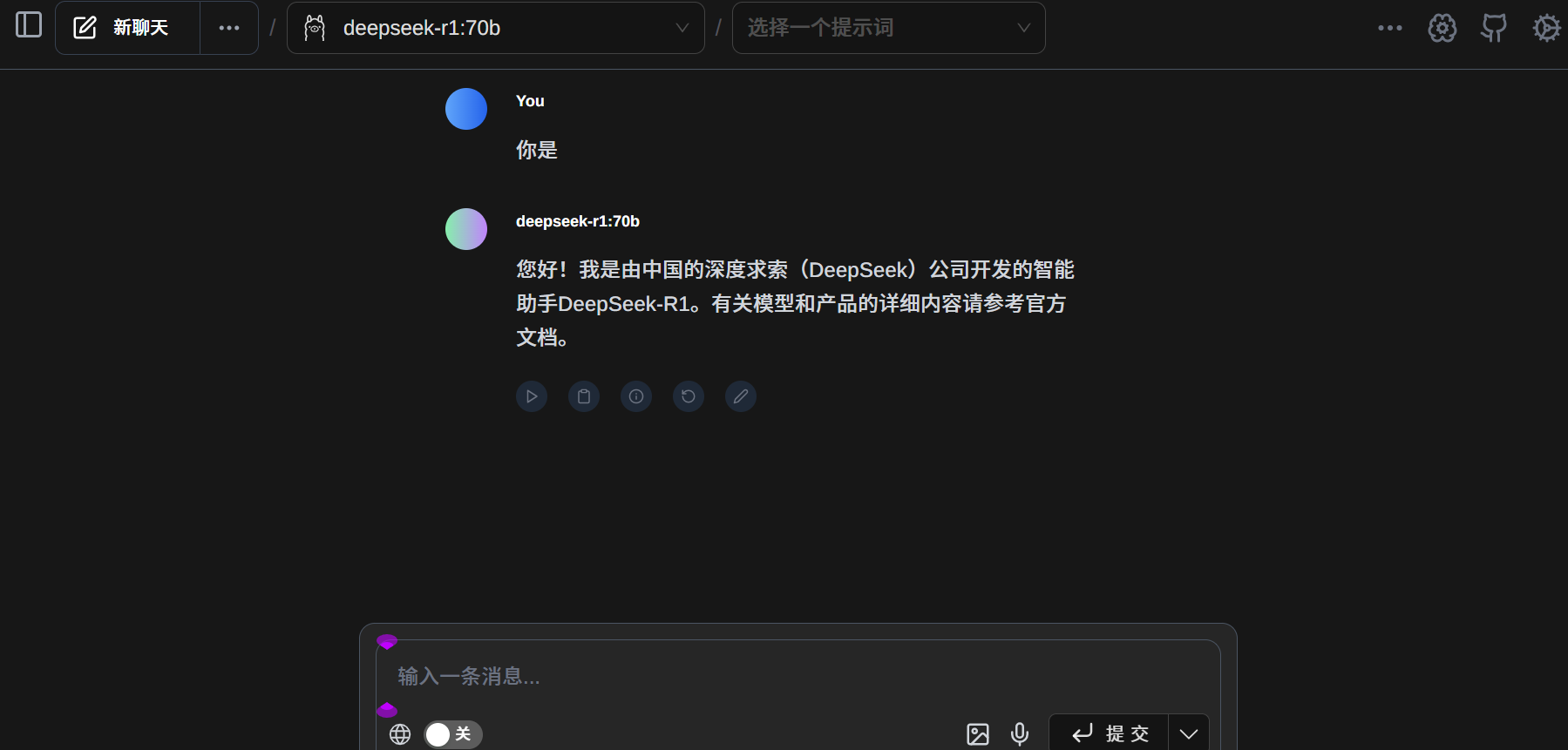

安装完成打开后,点击右上角"设置-ollama设置",启用ollama URL的高级配置

在OllamaURL与自定义来源URL上均填写"http://服务器ip+监听端口"

保存并刷新页面,出现如下"Ollama正在运行则表示成功”:

验证成功!

网络扫描Ollama端口

注:此方法用于技术交流,仅供个人使用,不要用于非法用途。

基本原理:

由于ollama运行于服务器的外网端口,人人皆可访问,因此可以使用此“特性”扫描全部的ip+端口,然后在http地址后加上"/api/tags"标签,即可查看当前ollama所运行的模型名称和代码。

例如:扫描出来111.111.111.111:11343存在ollama,仅需输入网址"http://111.111.111.111:11343/api/tags"即可查看ollama所部署的模型名称。

常用的扫描手段:1.python网络扫描 2.某些公开的扫描网站数据。

接下来以第二种方法为例:

FOTA扫描地址:

https://fofa.info/result?qbase64=YXBwPSJPbGxhbWEiICYmIGlzX2RvbWFpbj1mYWxzZSA%3D

shodan扫描地址:

https://www.shodan.io/search?query=Ollama+is+running

搜索到相中的模型之后,即可将此地址记录下来,粘贴到page assist中便可实现访问。

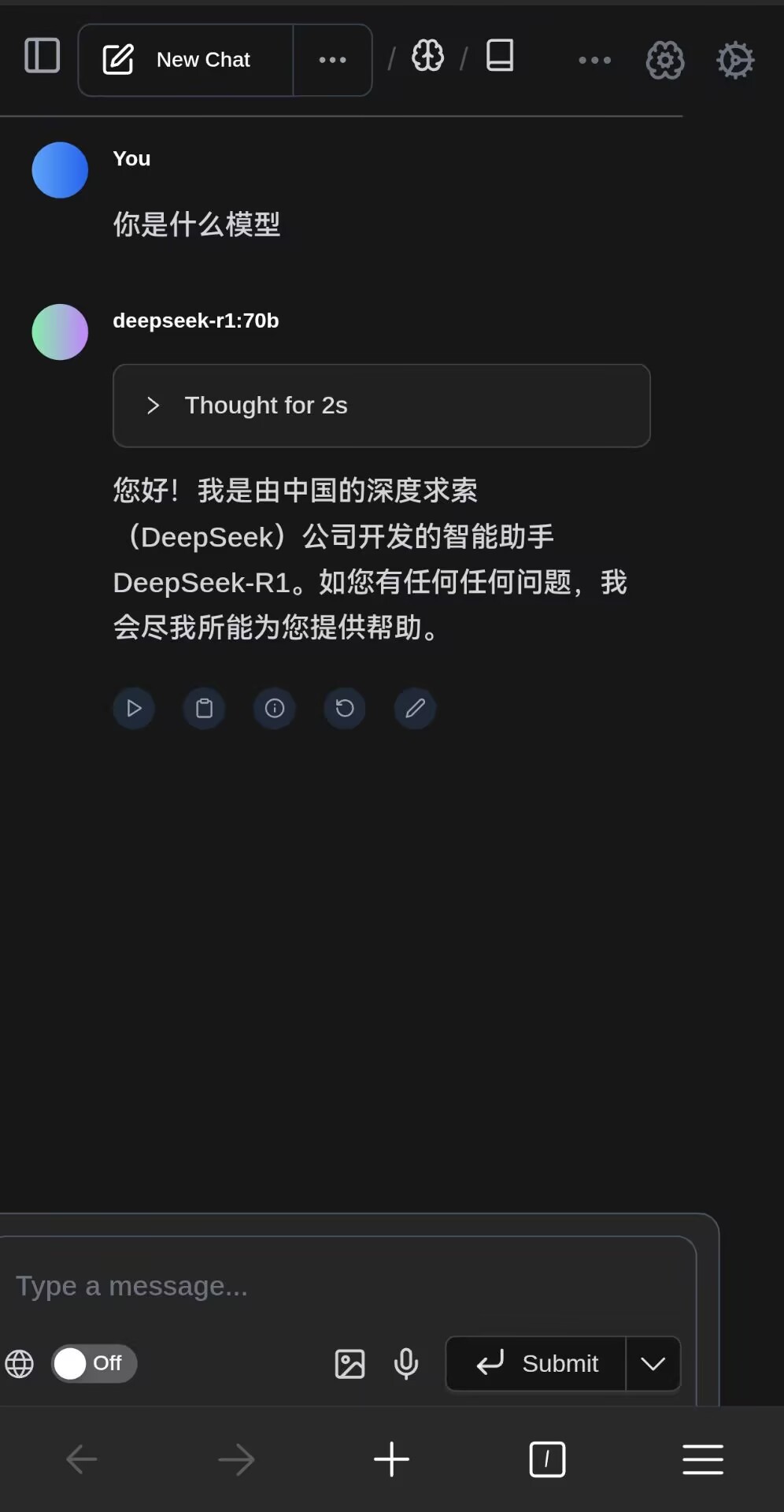

手机端调用page assist插件

手机端的edge官方版与edge windows不同,其不具备插件功能,需要在play store/apple store安装edge canary(已经完全具备插件功能)

edge canary:又名金丝雀,每日更新版本制,该版本会融入很多新功能或者说是需要不断的更新,注入新血液,也是工程师们大展手脚的版本。

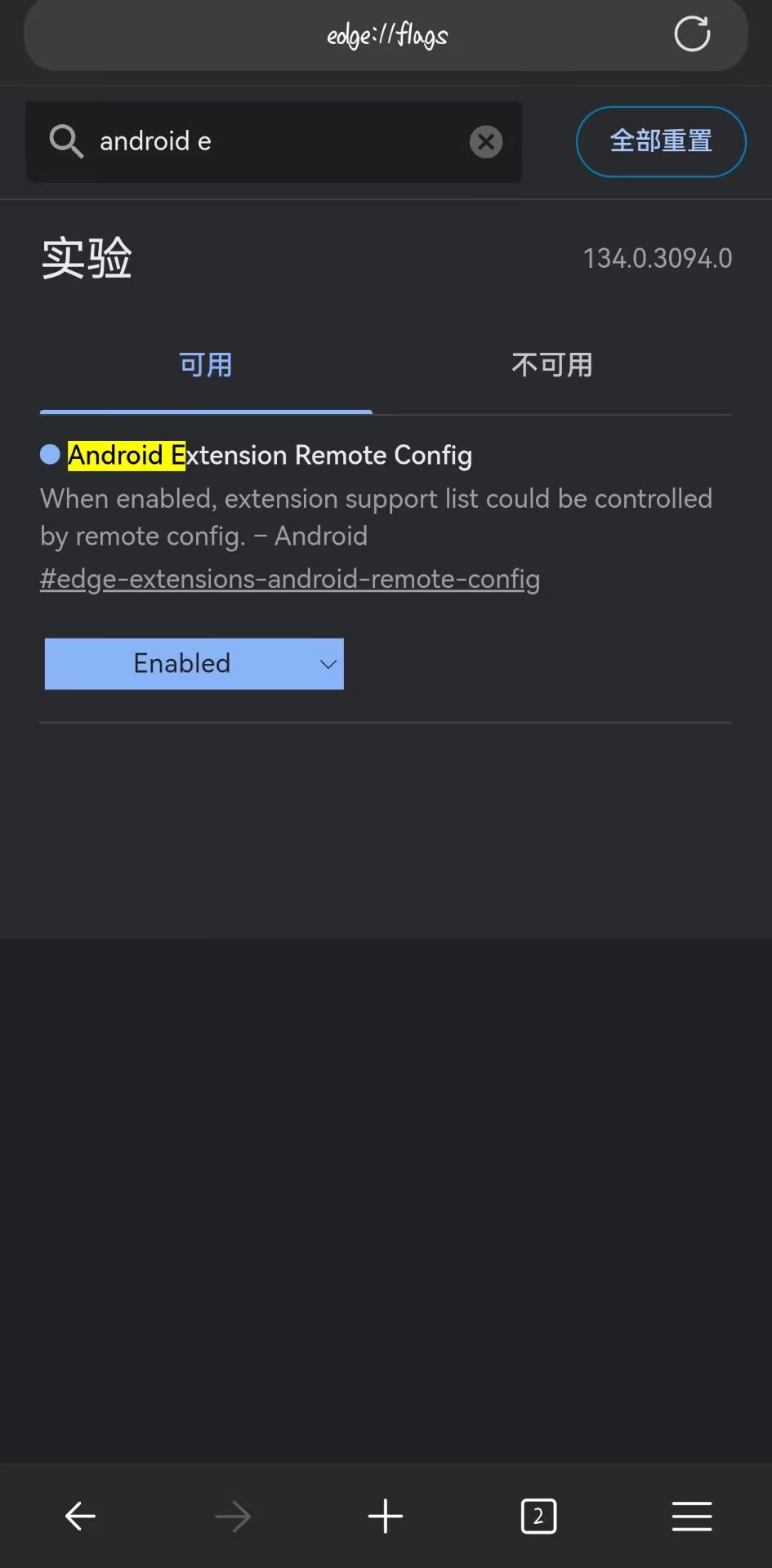

安装后输入edge://flags,

随后搜索"android extension"

将其调整为enabled,随后需要重启浏览器。

点击右下角三条杠,进入设置

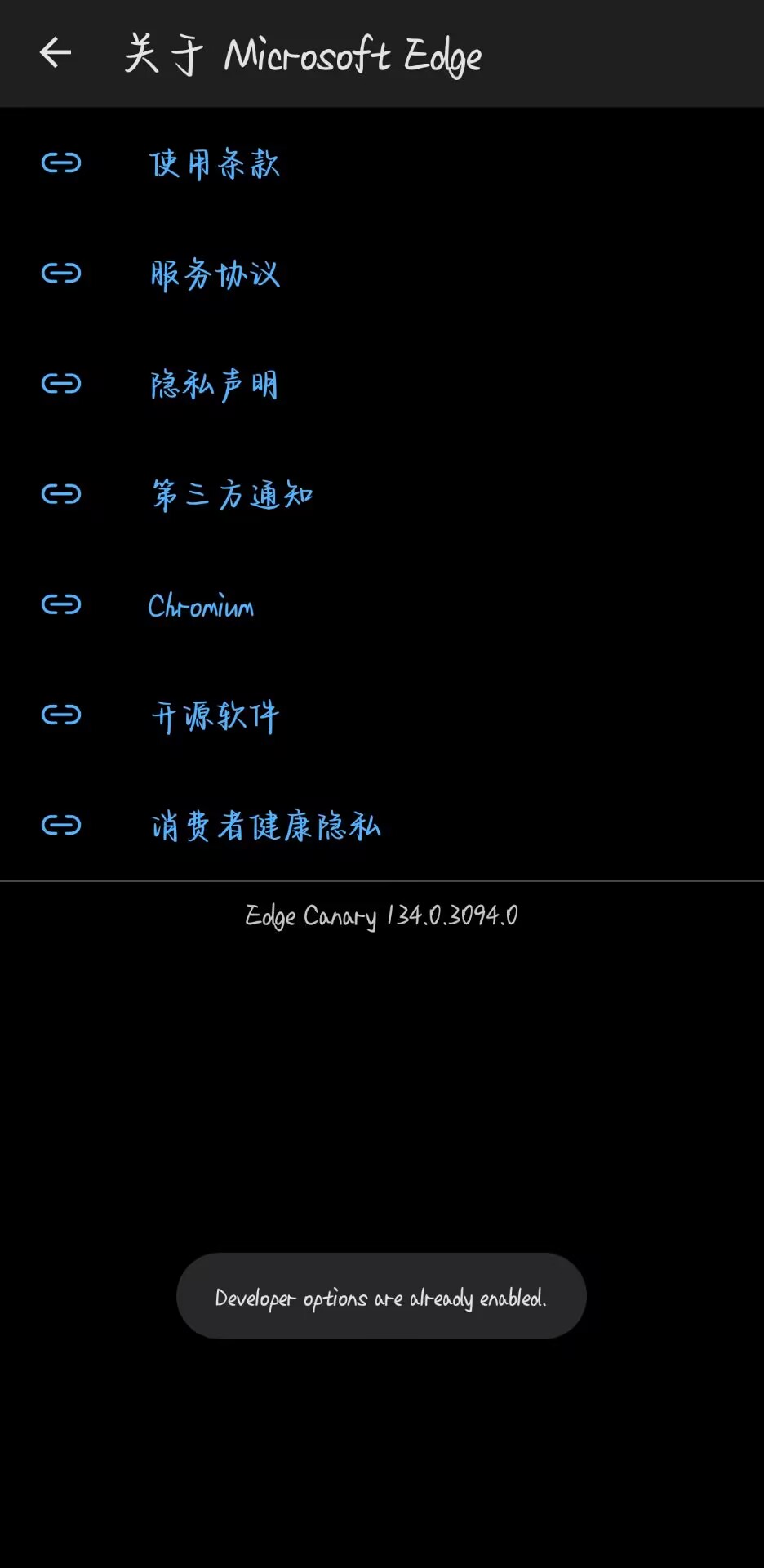

点击关于microsoft edge

点击5次版本,进入开发者模式

随后打开上面的page assist插件网站,下载crx格式插件。

在开发人员选项中找到extension install by crx,安装下载的crx插件

最后设置Ollama URL成功。